¿Cuál es la novedad de Inception Labs?

En el mundo de la inteligencia artificial, los Modelos de Lenguaje de Gran Escala (LLMs) han sido protagonistas de avances revolucionarios. Sin embargo, uno de los principales desafíos que enfrentan los modelos actuales es la velocidad y eficiencia de procesamiento.

Inception Labs ha abordado este problema con el lanzamiento de Mercury, una familia de Modelos de Lenguaje Basados en Difusión (dLLMs) que promete generar texto con alta calidad a una velocidad hasta 10 veces mayor que los modelos autoregresivos tradicionales. Este avance no solo mejora la eficiencia en el uso de recursos computacionales, sino que también reduce significativamente los costos asociados a la generación de texto en entornos empresariales y de desarrollo.

La Diferencia entre los Modelos de Lenguaje Tradicionales y los dLLMs

Los modelos de lenguaje tradicionales, como GPT-4 o Claude, utilizan una técnica denominada autoregresión, donde el texto es generado token por token, dependiendo del token anterior. Aunque este enfoque ha permitido grandes avances en el procesamiento del lenguaje natural (NLP), tiene ciertas limitaciones. La generación secuencial no solo ralentiza el proceso, sino que también restringe la capacidad de corrección de errores y revisión global del contenido generado.

Por otro lado, los Modelos de Lenguaje Basados en Difusión (dLLMs) emplean una metodología distinta. En lugar de generar texto token por token, comienzan con una secuencia «ruidosa» y la refinan iterativamente hasta obtener una salida coherente y estructurada. Este enfoque permite una generación mucho más rápida, ya que puede procesar varios tokens simultáneamente en paralelo, reduciendo la latencia y mejorando la coherencia del texto.

Mercury Coder: Optimización en la Generación de Código

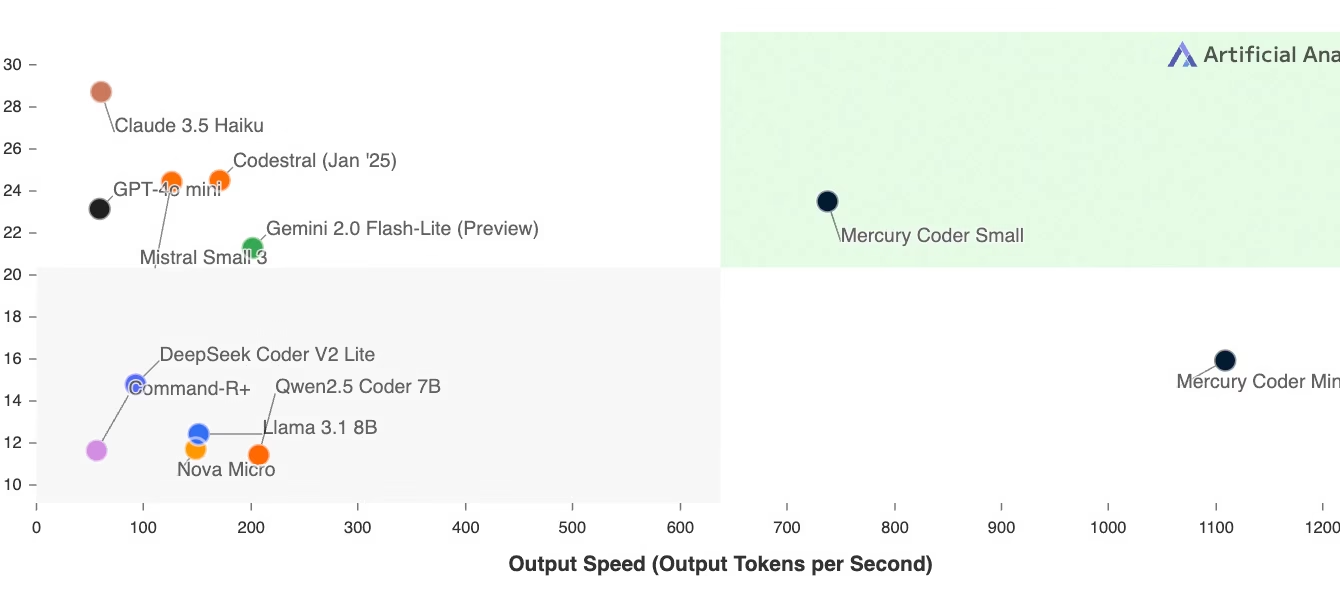

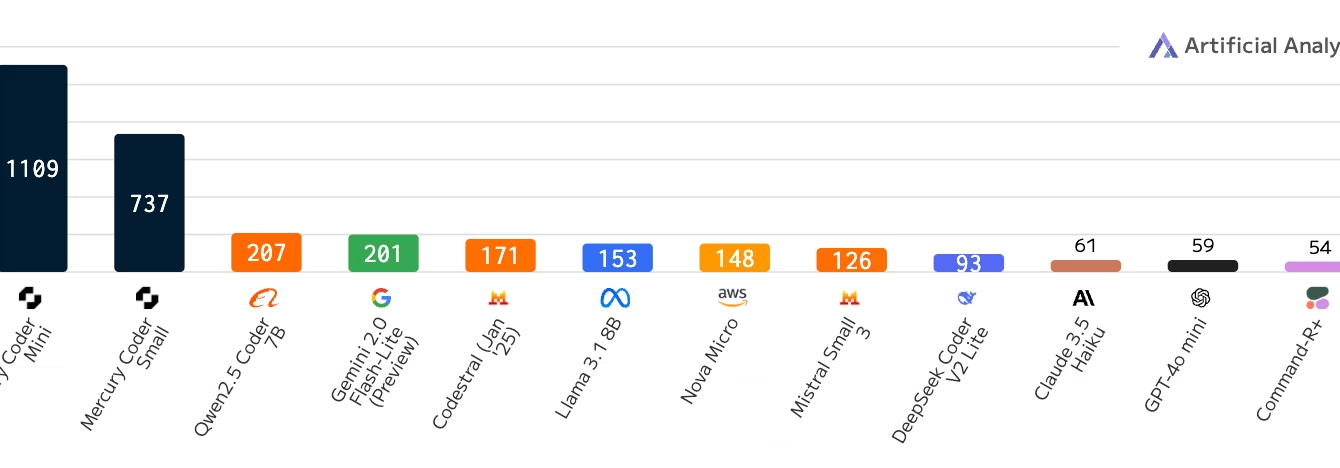

Uno de los primeros modelos de la familia Mercury en estar disponible públicamente es Mercury Coder, diseñado específicamente para la generación de código. Su desempeño en evaluaciones estándar ha demostrado que no solo iguala, sino que incluso supera a modelos reconocidos como GPT-4o Mini y Claude 3.5 Haiku en términos de calidad y velocidad.

En pruebas de rendimiento, Mercury Coder ha alcanzado velocidades de más de 1000 tokens por segundo en hardware NVIDIA H100, lo que representa una mejora sustancial sobre los modelos autoregresivos optimizados, que generalmente no superan los 200 tokens por segundo. Esta rapidez en la generación de código permite a los desarrolladores escribir, depurar y probar software de manera mucho más eficiente, reduciendo el tiempo necesario para completar proyectos.

Ventajas Claves de Mercury y los Modelos Basados en Difusión

1. Velocidad y Eficiencia Mejoradas

Los modelos de lenguaje basados en difusión pueden generar grandes cantidades de texto en menos tiempo, reduciendo los costos de procesamiento y mejorando la capacidad de respuesta en aplicaciones en tiempo real.

2. Menos Errores y Mayor Coherencia

Al refinar iterativamente el texto, los dLLMs pueden detectar y corregir errores durante el proceso de generación, reduciendo la incidencia de alucinaciones (errores en la información generada) y mejorando la calidad general del texto.

3. Mejora en el Razonamiento Complejo

Gracias a su estructura de generación global, los dLLMs pueden abordar tareas más complejas, como la resolución de problemas lógicos, el análisis de datos y la estructuración de textos extensos con mayor coherencia.

4. Aplicaciones Versátiles

Los modelos de la familia Mercury pueden ser utilizados en diversas aplicaciones, incluyendo:

- Automatización de Procesos Empresariales

- Asistentes Virtuales Inteligentes

- Generación de Contenido

- Desarrollo y Depuración de Código

- Sistemas de Recuperación de Información (RAG)

5. Reducción de Costos Computacionales

Debido a su eficiencia mejorada, los dLLMs requieren menos recursos para ofrecer el mismo nivel de rendimiento que los modelos tradicionales, lo que se traduce en una reducción de costos operativos.

Integración y Acceso a Mercury

Para aquellos interesados en experimentar con Mercury Coder, Inception Labs ofrece acceso a través de una plataforma interactiva donde los desarrolladores pueden probar sus capacidades en diferentes escenarios de programación. Además, para clientes empresariales, está disponible una API que permite integrar el modelo en diversas infraestructuras tecnológicas, incluyendo despliegues locales para garantizar seguridad y privacidad.

Implicaciones Futuras en el Desarrollo de IA

El desarrollo de modelos de lenguaje basados en difusión podría marcar un antes y un después en el campo de la inteligencia artificial. La capacidad de generar texto de manera rápida y precisa no solo impactará la productividad de los desarrolladores de software, sino también podría redefinir el modo en que interactuamos con los sistemas de IA en diversos ámbitos.

Por ejemplo, podría facilitar la creación de asistentes virtuales más eficientes, mejorar la automatización en la redacción de informes empresariales, optimizar la generación de contenido en medios digitales y potenciar la investigación en campos como la medicina y la ciencia de datos.

En Resumen

El lanzamiento de Mercury y, en particular, de Mercury Coder, representa un avance significativo en la evolución de los modelos de lenguaje. Gracias a la implementación de tecnología de difusión, Inception Labs ha conseguido un modelo que no solo mejora la velocidad de generación, sino que también incrementa la calidad y coherencia de los textos generados.

A medida que la tecnología continúa avanzando, es probable que los dLLMs se conviertan en un estándar dentro del ecosistema de la inteligencia artificial, proporcionando soluciones más ágiles y accesibles para una amplia gama de aplicaciones. Para aquellos interesados en probar Mercury Coder y evaluar su desempeño en escenarios del mundo real, pueden acceder a más información a través de la página oficial de Inception Labs.