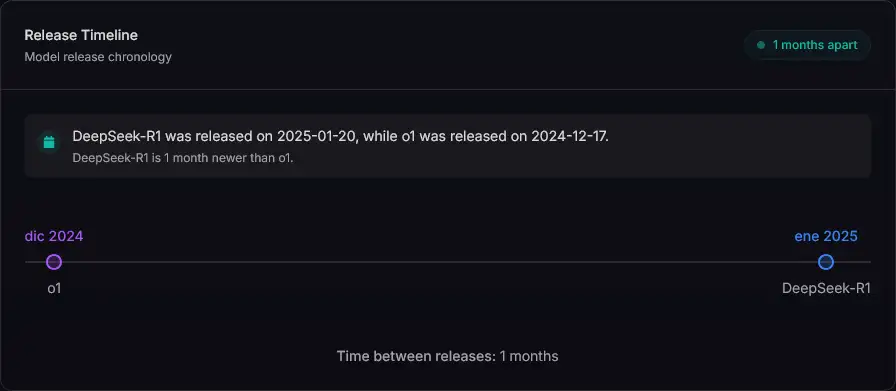

El mundo de los modelos de lenguaje sigue evolucionando a un ritmo acelerado, y la competencia entre DeepSeek-R1 y ChatGPT o1 marca un nuevo capítulo en la inteligencia artificial generativa. Mientras que ChatGPT o1 representa la última apuesta de OpenAI en modelos propietarios con alto rendimiento, DeepSeek-R1 se posiciona como una alternativa open-source y rentable con licenciamiento MIT.

En este artículo, exploraremos en detalle cada modelo, evaluando sus fortalezas y debilidades en términos de precisión, escalabilidad, costos, acceso y usabilidad. También discutiremos qué modelo es mejor para cada tipo de usuario y cómo podrían evolucionar en los próximos años.

Visión General de los Modelos

Para comprender mejor las diferencias fundamentales entre DeepSeek-R1 y ChatGPT o1, revisemos sus características principales y lo que los hace únicos en el ecosistema de IA actual.

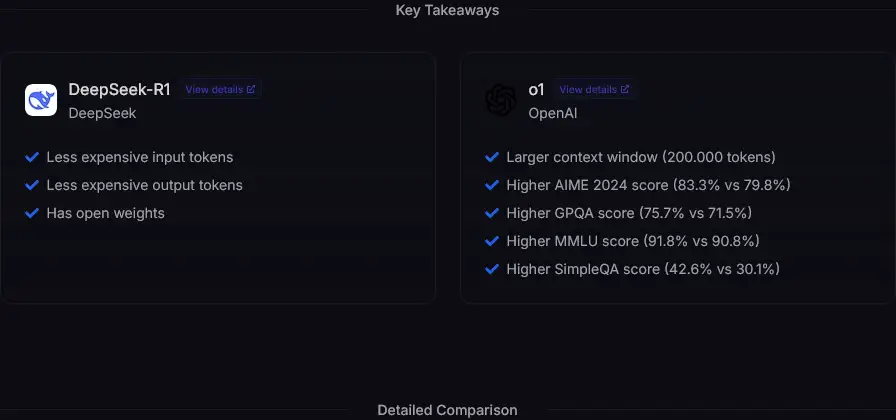

✅ DeepSeek-R1

- Modelo open-source con licencia MIT, totalmente accesible para desarrolladores y empresas.

- Costos reducidos, mucho más barato que las opciones de OpenAI.

- Alta disponibilidad, ya que puede ejecutarse en diversas plataformas como DeepInfra, Fireworks y Together.

- Competitivo en rendimiento, aunque inferior a ChatGPT o1 en benchmarks, sigue siendo una opción viable.

🚫 Desventajas:

- Menor capacidad de contexto (131K tokens frente a los 200K de o1).

- Menor optimización en tareas complejas como preguntas de conocimiento profundo y generación de texto avanzado.

✅ ChatGPT o1

- Mayor precisión en benchmarks, obteniendo mejores puntuaciones en AIME 2024, GPQA y MMLU.

- Capacidad de contexto superior (200K tokens), ideal para tareas con documentos extensos.

- Mejor optimización en tareas creativas y técnicas, con más consistencia en generación de código y análisis de información detallada.

🚫 Desventajas:

- Modelo propietario, limitado a la infraestructura de OpenAI y Azure.

- Costo significativamente más alto, con una diferencia de hasta 30 veces en comparación con DeepSeek-R1.

Comparación de Rendimiento en Benchmarks

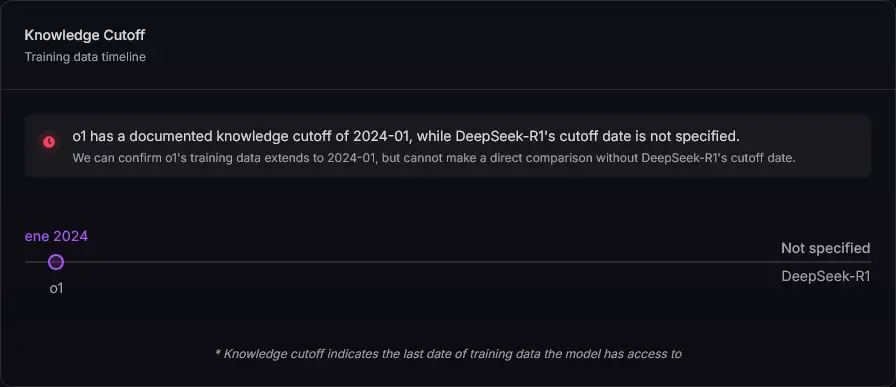

Los benchmarks son una métrica clave para evaluar la calidad de un modelo de IA. En esta comparativa, los datos se han obtenido de llm-stats.com, un sitio de referencia que recopila y actualiza continuamente resultados de pruebas estandarizadas.

| Benchmark | DeepSeek-R1 | ChatGPT o1 |

|---|---|---|

| AIME 2024 | 79.8% | 83.3% |

| GPQA | 71.5% | 75.7% |

| MMLU | 90.8% | 91.8% |

| SimpleQA | 30.1% | 42.6% |

📌 Interpretación de los datos:

Aunque ChatGPT o1 tiene mejor desempeño general, las diferencias no son abismales en la mayoría de los benchmarks. Sin embargo, en SimpleQA se observa una diferencia más marcada (30.1% vs. 42.6%), lo que podría ser determinante en aplicaciones específicas donde la capacidad de respuesta a preguntas simples sea crucial.

No obstante, DeepSeek-R1 sigue siendo competitivo, especialmente considerando que cuesta hasta 30 veces menos.

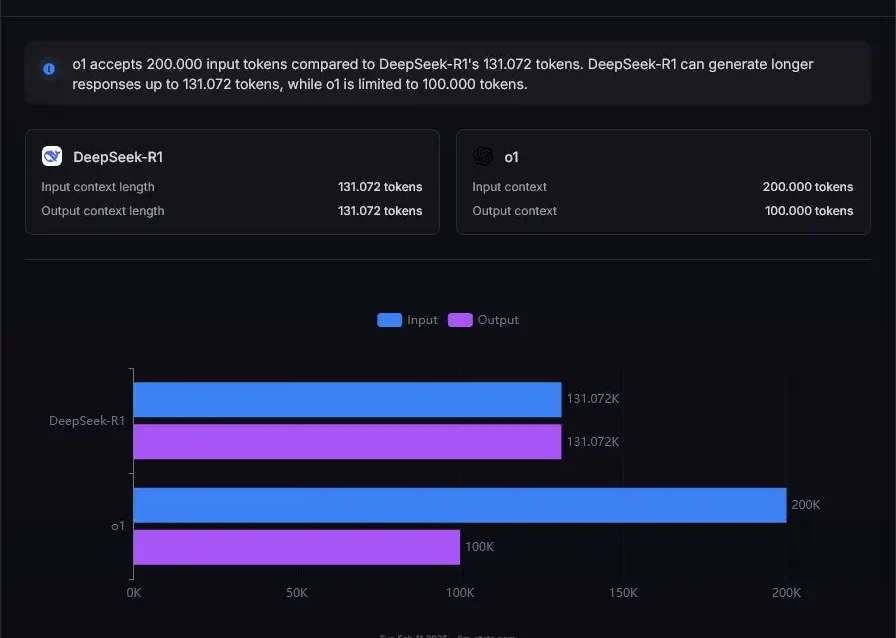

Capacidad de Contexto y Procesamiento de Datos

Una de las mayores diferencias entre los modelos es la cantidad de tokens que pueden manejar:

Uno de los factores más relevantes en la comparación es la capacidad de contexto, que define cuántos tokens pueden manejar estos modelos en una conversación o documento.

| Modelo | Tokens de Entrada | Tokens de Salida |

|---|---|---|

| ChatGPT o1 | 200K | 100K |

| DeepSeek-R1 | 131K | 131K |

📌 Casos de uso:

- ChatGPT o1 es ideal para procesar documentos extensos, realizar análisis de datos de gran escala y manejar interacciones prolongadas sin pérdida de contexto.

- DeepSeek-R1, aunque más limitado en este aspecto, sigue siendo una opción válida y rentable para tareas más cortas.

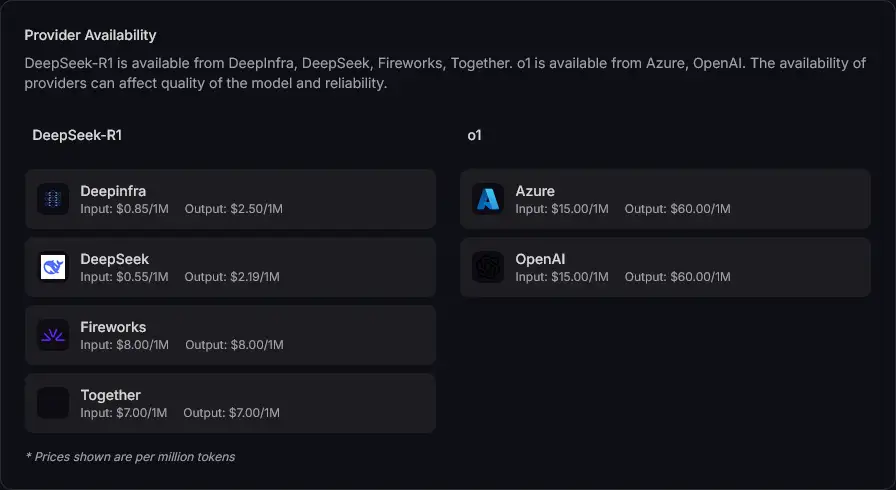

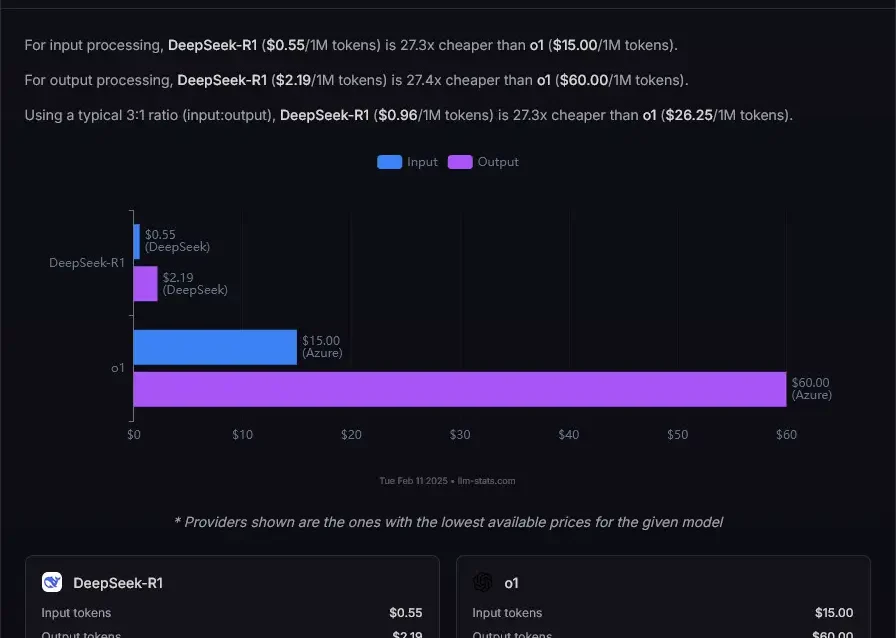

Costos y Disponibilidad

Los costos son un factor clave al elegir entre estos modelos, especialmente para empresas que necesitan procesar grandes volúmenes de texto.

DeepSeek-R1:

- Entrada: $0.55 – $0.85 por millón de tokens.

- Salida: $2.19 – $2.50 por millón de tokens.

- Disponible en: DeepInfra, Fireworks, Together.

ChatGPT o1:

- Entrada: $15 por millón de tokens.

- Salida: $60 por millón de tokens.

- Disponible en: Azure y OpenAI.

📌 Conclusión sobre costos:

Si el presupuesto es una prioridad, DeepSeek-R1 es la opción más rentable. Sin embargo, para quienes buscan rendimiento superior, ChatGPT o1 justifica su costo con un mayor poder de procesamiento.

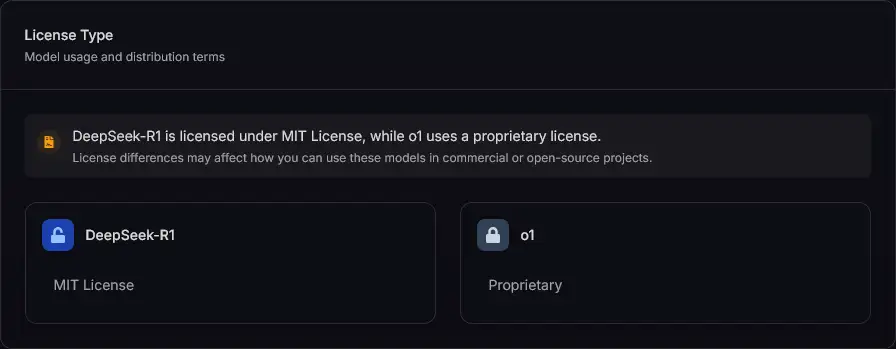

Licenciamiento y Accesibilidad

Un aspecto clave es el tipo de licencia que utiliza cada modelo:

- DeepSeek-R1 usa licencia MIT, lo que significa que es completamente open-source y modificable.

- ChatGPT o1 es propietario de OpenAI, lo que restringe su acceso a desarrolladores externos.

Conclusión:

Si necesitas personalizar o modificar el modelo, DeepSeek-R1 es la mejor opción. Si buscas rendimiento sin preocuparte por acceso al código fuente, ChatGPT o1 es superior.

Futuro de Ambos Modelos

DeepSeek-R1

- Al ser open-source, su adopción puede crecer rápidamente, especialmente si más empresas buscan independencia de grandes proveedores propietarios.

- La comunidad open-source puede aportar mejoras continuas, aunque se debe considerar la inversión en infraestructura y soporte técnico.

ChatGPT o1

- Seguirá mejorando en rendimiento y optimización, pero su alto costo puede limitar su uso a sectores empresariales con presupuestos elevados.

- Su evolución dependerá de OpenAI y su capacidad para justificar el valor premium de su servicio.

📌 ¿Podría DeepSeek-R1 ser una alternativa real a OpenAI en el futuro?

Si continúa evolucionando y optimizando su rendimiento, podría convertirse en una opción principal para desarrolladores e investigadores, especialmente en proyectos que prioricen la flexibilidad y la independencia tecnológica.

Entonces: ¿Cuál elegir?

| Recomendación | DeepSeek-R1 | ChatGPT o1 |

|---|---|---|

| Mejor en costos | ✅ | ❌ |

| Mayor capacidad de contexto | ❌ | ✅ |

| Mayor precisión en respuestas | ❌ | ✅ |

| Open-source | ✅ | ❌ |

🔹 Usa DeepSeek-R1 si…

✔️ Buscas una opción económica y de código abierto.

✔️ Necesitas independencia de OpenAI.

🔹 Usa ChatGPT o1 si…

✔️ Quieres máxima precisión y rendimiento.

✔️ Trabajas con documentos extensos o proyectos exigentes.

Ambos modelos representan diferentes enfoques en el mercado de IA, y la elección dependerá de las prioridades del usuario. ¿Cuál prefieres? 🚀

Este análisis, basado en datos extraídos de llm-stats.com, ofrece una visión clara y transparente de las capacidades y limitaciones de cada modelo. Al considerar tanto los aspectos técnicos como los costos y el modelo de licenciamiento, los usuarios pueden tomar una decisión informada acorde a sus necesidades y recursos.